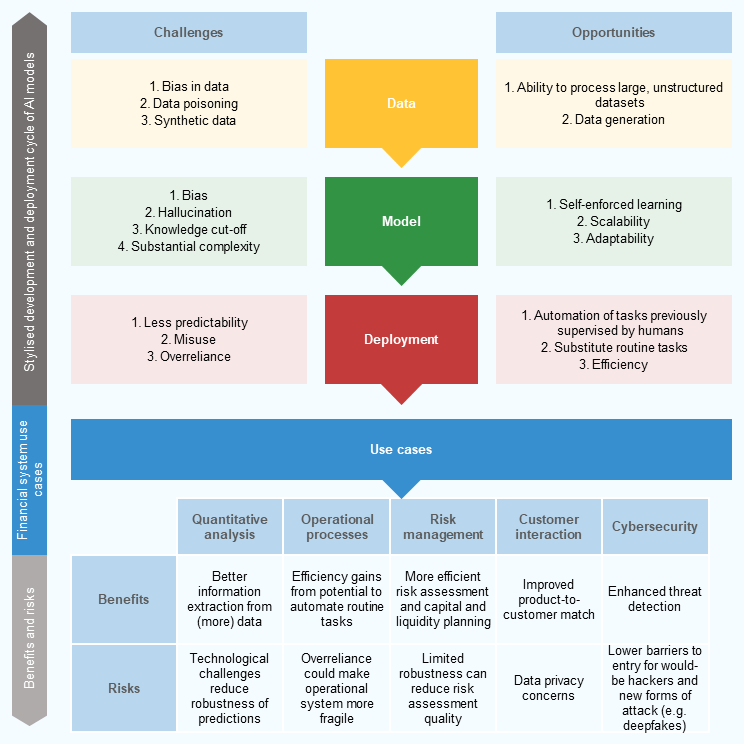

L’adozione dell’intelligenza artificiale (AI) e, in particolare, dei modelli generativi basati su Large Language Models (LLMs), sta rivoluzionando il settore finanziario. Questi progressi tecnologici offrono opportunità significative, come l’automazione dei processi, il miglioramento delle previsioni di mercato, l’ottimizzazione delle strategie di trading e l’aumento dell’efficienza operativa.

Tuttavia, l’implementazione di tali tecnologie comporta anche rischi considerevoli, tra cui la possibilità di decisioni errate dovute a modelli mal addestrati, problemi di sicurezza e privacy dei dati, e la potenziale riduzione del ruolo umano nel processo decisionale.

L’ultimo Financial Stability Review[1] pubblicato dalla Banca Centrale Europea il 16 maggio 2024[2], dedica un’ampia trattazione anche all’ascesa dell’intelligenza artificiale e i benefici e i rischi che essa comporta per la stabilità finanziaria.

Comprendere potenzialità e limiti dell’AI e degli LLMs

È quindi fondamentale per le istituzioni finanziarie comprendere appieno le potenzialità e i limiti dell’AI e degli LLMs. Devono investire in una formazione adeguata per i loro dipendenti, sviluppare strategie di gestione del rischio che includano queste nuove tecnologie e collaborare con esperti del settore per garantire che l’integrazione dell’AI avvenga in modo sicuro ed etico.

Inoltre, le istituzioni devono essere pronte a adattarsi rapidamente ai cambiamenti regolamentari che potrebbero sorgere in risposta all’uso crescente di queste tecnologie innovative. Solo con un approccio consapevole e informato, le istituzioni finanziarie potranno sfruttare appieno i benefici dell’AI, contenendo al contempo i potenziali rischi.

In questo articolo proponiamo una breve disamina dei contenuti estratti dal report BCE suddetto, evidenziando benefici e rischi che l’adozione di sistemi basati essenzialmente sull’intelligenza artificiale generativa, proponendo alcuni spunti di riflessione a cura di scrive, indirizzati a mitigare taluni rischi dipesi dalla contaminazione di bias nelle sorgenti di dati provviste ai modelli fondazionali.

Che cos’è l’intelligenza artificiale generativa

L’intelligenza artificiale generativa (spesso chiamata con la crasi “GenAI” Generative Artificial Intelligence) è una forma avanzata di AI che utilizza modelli di apprendimento automatico per creare nuovi contenuti simili a quelli prodotti dagli esseri umani. Questa tecnologia è alla base di molte applicazioni innovative e rivoluzionarie in diversi settori, fra cui quello finanziario di cui trattiamo in questo articolo.

Foundation Models e Large Language Models (LLMs)

I modelli di intelligenza artificiale generativa appartengono di norma a una categoria più ampia chiamata “Foundation Models“. Addestrati su grandi quantità di dati, questi modelli sono progettati per essere versatili e adattabili a un’ampia gamma di compiti. Costituiscono la base per molte applicazioni GenAI, inclusi il riconoscimento delle immagini, la sintesi vocale e l’elaborazione del linguaggio naturale (NLP).

All’interno dei Foundation Models, troviamo una sottocategoria specializzata chiamata “Large Language Models” (o, più semplicemente, “LLMs”). Gli LLMs come, ad esempio, GPT di OpenAI, Google Gemini, Claude, sono progettati specificamente per comprendere, generare e interagire con il linguaggio umano. Tali modelli possono eseguire compiti complessi come la generazione di testo, la traduzione automatica e la risposta a domande.

I benefici dell’intelligenza artificiale generativa

L’AI generativa offre vantaggi notevoli in termini di gestione dei dati, efficienza operativa e personalizzazione dei servizi. Questi benefici stanno già trasformando il modo in cui le istituzioni finanziarie operano e interagiscono con i clienti.

Miglioramento della gestione dei dati

La GenAI abilita capacità avanzate di gestione e analisi dei dati, permettendo di elaborare non solo dati numerici ma anche testi, codici, voce e immagini. Una siffatta capacità di analizzare dati non strutturati consente una visione più dettagliata delle operazioni finanziarie e del comportamento dei clienti.

Le istituzioni finanziarie possono utilizzare queste informazioni per migliorare la precisione delle previsioni economiche e per ottimizzare le strategie di investimento. Inoltre, la possibilità di elaborare grandi volumi di dati in tempo reale permette una reattività superiore ai cambiamenti di mercato, migliorando la gestione del rischio.

Efficienza operativa

I modelli di AI possono essere adattati per svolgere compiti specifici, migliorando notevolmente l’efficienza operativa. Ad esempio, nel credit scoring, l’AI può valutare il rischio di credito in modo più accurato e rapido rispetto ai metodi tradizionali, grazie alla capacità di analizzare variabili più complesse e dati non convenzionali.

Nel rilevamento delle frodi, l’AI può identificare pattern sospetti in tempo reale, riducendo il rischio di perdite finanziarie. Inoltre, l’automazione di processi ripetitivi e laboriosi consente alle istituzioni di ridurre i costi operativi e di liberare risorse per attività a maggior valore aggiunto.

Personalizzazione dei servizi

L’adozione di LLMs permette di offrire servizi personalizzati ai clienti. Utilizzando modelli di machine learning, le banche possono analizzare le preferenze e i comportamenti dei clienti per offrire prodotti e servizi su misura. Questa personalizzazione può andare oltre la semplice offerta di prodotti finanziari, includendo consigli personalizzati su investimenti, gestione patrimoniale e servizi di consulenza finanziaria. Migliorando l’esperienza del cliente, le istituzioni possono aumentare la soddisfazione e la fidelizzazione, ottenendo al contempo preziose informazioni per sviluppare ulteriormente i propri servizi.

I rischi dell’intelligenza artificiale generativa

Nonostante i benefici, l’adozione dell’intelligenza artificiale generativa comporta rischi legati alla qualità dei dati, alla complessità e trasparenza dei modelli, alla privacy e sicurezza dei dati, e alle implicazioni per la stabilità finanziaria.

Problemi di qualità dei dati

Tra i problemi che affliggono gli LLMs, rileva la presenza di bias incorporati nei dati di addestramento, portando a interpretazioni distorte delle dinamiche del mercato finanziario. Bias di questo tipo possono derivare da dati storici non rappresentativi o parziali, che riflettono pregiudizi sistematici. Se i modelli di GenAI utilizzano tali dati per fare previsioni o prendere decisioni, il rischio è che queste risultino distorte, causando inefficienze nel mercato. Un esempio di tali distorsioni potrebbe essere una valutazione errata del rischio di credito, influenzando negativamente le scelte di allocazione del capitale.

Il problema dei bias

Gli LLMs possono perpetuare pregiudizi presenti nei dati storici, influenzando sfavorevolmente le decisioni di mercato. Ad esempio, pregiudizi verso determinati settori o asset possono portare a distorsioni nei prezzi di mercato e a decisioni di investimento sbilanciate. Inoltre, la mancanza di aggiornamenti frequenti nei dati può dar adito alla generazione di previsioni basate su informazioni obsolete, riducendo l’affidabilità delle decisioni. La gestione della qualità dei dati e l’implementazione di algoritmi di mitigazione dei bias sono cruciali per garantire previsioni affidabili e decisioni equilibrate.

Inoltre, se i modelli di IA soffrono di bias incorporati e vengono utilizzati ampiamente per comprendere le dinamiche del mercato finanziario, il pericolo di uniformare l’interpretazione delle informazioni è considerevole. Ciò comporta il rischio che le conclusioni dei partecipanti al mercato diventino sistematicamente distorte, portando a prezzi degli asset alterati, comportamento gregario e potenziali bolle speculative.

Alcune soluzioni per mitigare i bias

Chi scrive ha avuto l’opportunità di trattare nello specifico questi problemi[3], rappresentando l’opportunità offerta da RAG[4], blockchain, NFT e Decentralized Governance per prevenire gli effetti indesiderati dei bias, cui le sorgenti impiegate da LLMs sono esposti.

Nello specifico, con il supporto della RAG (Retrieval Augmented Generation), sarebbe possibile controllare le fonti informative a integrazione delle basi di dati su cui sono addestrati gli LLMs, grazie all’impiego della blockchain e di token non fungibili. Questi ultimi, consentirebbero un accesso selettivo ai contributori delle fonti di addestramento aggiuntive, implementando meccanismi di token gating e offrendo al contempo la possibilità di firmare digitalmente le medesime, potendovi infine apporre un timestamp quale mezzo di datacertazione.

Inoltre, allo scopo di inibire comportamenti sleali o anche solo inidonei per la qualità delle fonti provvedute, l’operato dei contributori, le regole d’ingaggio e la retribuzione degli stessi, potrebbero essere governati in modo decentralizzato, creando una DAO (Decentralized Autonomous Organization). In tal modo si potrebbero mitigare i rischi di un’eccessiva concentrazione di potere, ad appannaggio di una migliore eterogeneità dei valori e dei diritti rappresentati (c’è chi chiama questo processo “democratizzazione” dell’intelligenza artificiale).

Complessità e trasparenza

La complessità intrinseca dei modelli di AI generativa rende difficile per gli esseri umani comprendere e ricostruire le previsioni fatte. Questa mancanza di trasparenza può ridurre la fiducia nelle decisioni basate sull’AI generativa e complicare la governance e la supervisione dei processi decisionali automatizzati. È essenziale sviluppare modelli di AI che siano interpretabili e spiegabili, in modo che gli operatori “umani” possano comprendere le logiche sottostanti alle decisioni prese dall’AI. Così facendo si migliorerebbe la fiducia e si permetterebbe una migliore integrazione tra decisioni automatizzate e giudizio umano.

Un’impostazione umano-centrica

Sul punto vale ricordare, all’avviso di chi scrive, come un’impostazione “umano-centrica” di questo tipo rinviene sin dagli albori della cosiddetta “società 5.0”[5], uno schema di “super-società” in cui l’uomo e le tecnologie innovative convivono, mutuandosi reciprocamente apporti e benefici. Un modello nel quale la democratizzazione dei dati e dell’accesso ai medesimi reso possibile dalla blockchain, consente di esprimere in modo efficacie e sostenibile un valore universale che affranca l’uomo dal rischio di spersonalizzazione, ri-ponendolo al centro delle dinamiche tecno-evolutive di un ecosistema del quale è autore e, al tempo stesso, interprete[6].

Privacy e sicurezza dei dati

L’uso estensivo della GenAI solleva preoccupazioni riguardo alla sicurezza dei dati. Le istituzioni finanziarie devono garantire la protezione dei dati sensibili dei clienti e prevenire violazioni della privacy. La gestione della sicurezza dei dati deve includere misure avanzate di crittografia, controllo degli accessi e monitoraggio continuo per rilevare e rispondere tempestivamente a eventuali violazioni. Inoltre, la dipendenza da terze parti per la fornitura di tecnologie AI introduce ulteriori rischi di sicurezza, come cyberattacchi e perdita di dati, che devono essere attentamente gestiti tramite accordi contrattuali e audit regolari.

Implicazioni per la stabilità finanziaria dell’intelligenza artificiale generativa

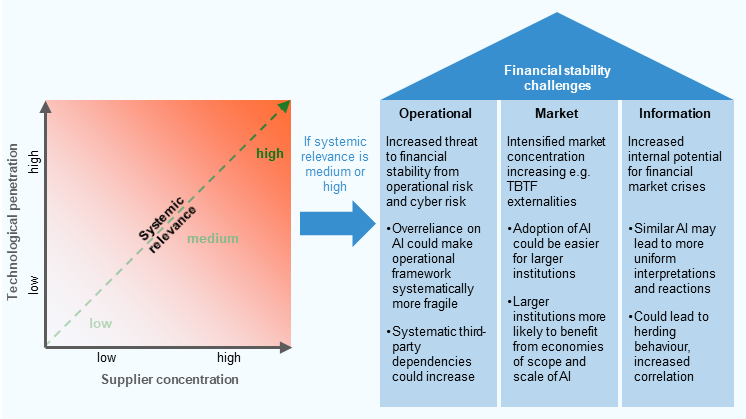

L’adozione diffusa dei modelli fondazionali, su cui si basano gli LLMs, in vari settori finanziari può amplificare sia le opportunità sia le sfide, aumentando il potenziale impatto sistemico di eventuali malfunzionamenti o fallimenti tecnologici.

Una maggiore penetrazione tecnologica comporta una dipendenza crescente dalle tecnologie AI. È necessario implementare piani di continuità operativa e strategie di resilienza tecnologica per mitigare i rischi associati a interruzioni improvvise. La diversificazione delle tecnologie e dei fornitori può ridurre la vulnerabilità a problemi specifici di un singolo sistema o fornitore.

Concentrazione dei fornitori

La concentrazione dei fornitori di tecnologie AI rappresenta un rischio significativo. Se molte istituzioni finanziarie utilizzano modelli simili forniti da un numero limitato di provider, i bias e le sfide tecnologiche comuni possono risultare amplificati, aumentando la fragilità del sistema finanziario. È importante promuovere una diversificazione dei fornitori e lo sviluppo di soluzioni AI interne per ridurre la dipendenza da pochi grandi provider e mitigare i rischi di concentrazione.

Concentrazione del mercato

L’integrazione dell’AI richiede investimenti significativi, favorendo le istituzioni finanziarie più grandi e riducendo la concorrenza. Una tendenza siffatta può portare a una maggiore concentrazione del mercato e aumentare il rischio di esternalità basati sul postulato “too big to fail”.

Gli istituti di minor dimensione potrebbero non essere in grado di competere efficacemente, portando a una riduzione del numero di operatori sul mercato. Incentivi e supporto per l’adozione dell’AI generativa da parte delle istituzioni più piccole potrebbero aiutare a mantenere una concorrenza sana e diversificata.

Distorsione delle interpretazioni

L’uso diffuso degli LLMs nel mondo finance può uniformare l’interpretazione delle informazioni di mercato, portando a distorsioni nei prezzi degli asset e, se si parla di finanza comportamentale, a condotte influenzate dal cosiddetto “effetto gregge”[7].

Il propagarsi di tali interpretazioni distorsive può aumentare la volatilità del mercato e il rischio di bolle speculative, compromettendo la stabilità finanziaria. Le istituzioni finanziarie devono monitorare attentamente l’impatto delle decisioni basate sull’AI e sviluppare misure per mitigare i comportamenti gregari e altre distorsioni di mercato.

Conclusione

L’adozione dell’AI e dei modelli generativi basati su LLMs offre opportunità straordinarie per le istituzioni finanziarie, ma comporta anche rischi significativi che devono essere gestiti con attenzione.

Una comprensione approfondita dei benefici e dei rischi associati all’AI è essenziale per sfruttare appieno il potenziale di questa tecnologia, mantenendo al contempo la stabilità e la sicurezza del sistema finanziario.

I rischi dipesi dai bias di cui sono affetti i dati di addestramento dei modelli devono essere il più possibile limitati. L’utilizzo di tecniche basate su RAG in combinazione con la blockchain e i token potrebbe risultare, in tale direzione, molto efficace.

Le istituzioni devono adottare un approccio equilibrato, integrando l’innovazione con misure di controllo e gestione del rischio per garantire un utilizzo sostenibile e sicuro dell’AI.

Riportare l’uomo al centro è un processo che deve essere implementato con convinto ottimismo. Laddove le logiche sottostanti alle decisioni prese dall’AI dovessero sfuggire alla comprensione umana, il rischio di spersonalizzazione alimenterebbe scenari distopici che esporrebbero la finanza a rischi di natura sistemica.

Combattere l’interpretazione dei dati uniformata, individuare fornitori diversi, allocare capitale per investimenti in AI generativa in differenti zone del pianeta ad alto potenziale, lenisce i pericoli di fenomeni distorsivi del mercato, preserva la stabilità finanziaria, attenua il rischio geo-politico di concentrazioni di potere.

NOTE

[1] Il Financial Stability Review fornisce una panoramica dei rischi potenziali per la stabilità finanziaria nell’area dell’euro. Il suo scopo è sensibilizzare il settore finanziario e l’opinione pubblica sulle questioni relative alla stabilità finanziaria nell’area dell’euro.

[2] Financial Stability Review, BCE, 16 maggio 2024, https://www.ecb.europa.eu/press/financial-stability-publications/fsr/html/index.en.html (u.a. 16/5/2024).

[3] Webinar “BLOCKCHAIN E INTELLIGENZA ARTIFICIALE: LE SFIDE E LE OPPORTUNITÀ”, Garavaglia R., 13 maggio 20214, Osservatorio Blockchain & Web3 del Politecnico di Milano.

[4] RAG, o Retrieval-Augmented Generation, è una tecnologia nel campo dell’elaborazione del linguaggio naturale (NLP) che combina le tecniche di recupero delle informazioni con i modelli di generazione di testo.

[5] Il concetto di “Società 5.0” prende le mosse da alcune iniziative avviate in Giappone nel corso del 2017-2018, definendosi come una società centrata sull’uomo che integra il cyberspazio e lo spazio fisico.

[6] Si veda al riguardo il paragrafo “L’estensione dell’ambito di applicazione dei Non-Fungible Token” dell’articolo “Nel mondo dei token: gli sviluppi della token-economy e delle applicazioni decentralizzate”, Garavaglia R., Blockchain4Innovation, 22 gennaio 2020.

[7] Nell’ambito della finanza comportamentale, l’effetto gregge descrive la propensione delle persone a seguire e imitare le azioni di altri investitori. Anche se spesso non ne siamo consapevoli, si tratta di un bias cognitivo che influisce su molti aspetti della nostra vita. Questo comportamento ci fa sentire più sicuri e meno responsabili degli errori che potremmo commettere.